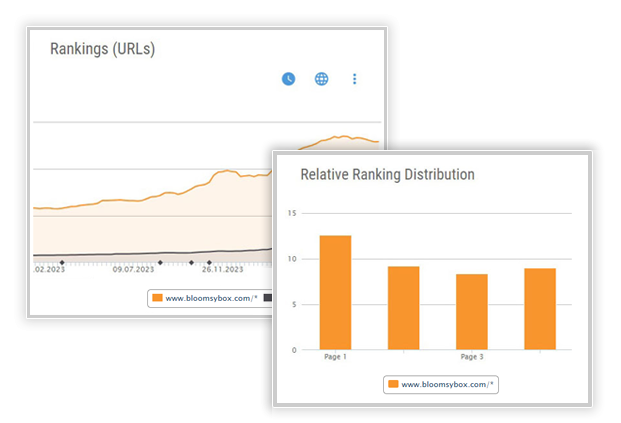

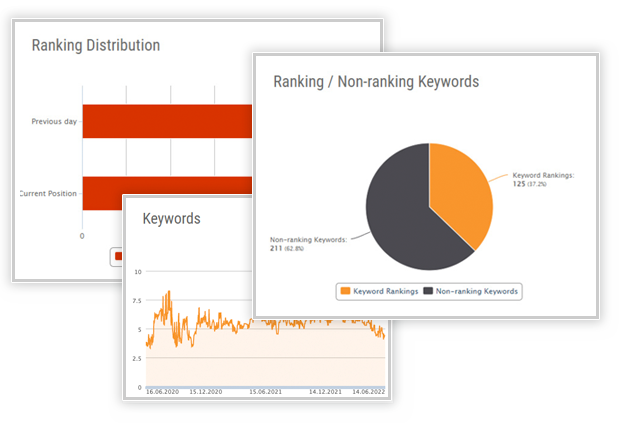

Rank tracking for your most important keywords

We Simplify SEO

THE XOVI FEATURES

Overview of XOVI features

The XOVI SEO check

An SEO check is a comprehensive review of your website’s search engine optimization (SEO). The XOVI tool analyzes whether your site aligns with Google’s ranking factors and provides actionable insights on how to optimize your website for better rankings. Additionally, the SEO check helps you ensure that individual pages are optimized for the most relevant search terms.

The XOVI Content Check

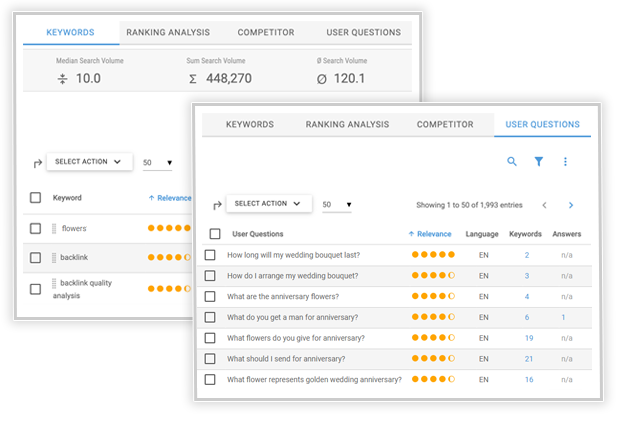

Use the question feature to identify user questions related to your keywords and address them directly in your content. This approach helps you create highly relevant, helpful content that resonates with users—and Google will reward you for it. With the Keyword Planner, you can gather valuable keywords, organize them into groups, label them as needed, and structure your content effectively. It also helps you develop fresh content ideas to further enhance your strategy.

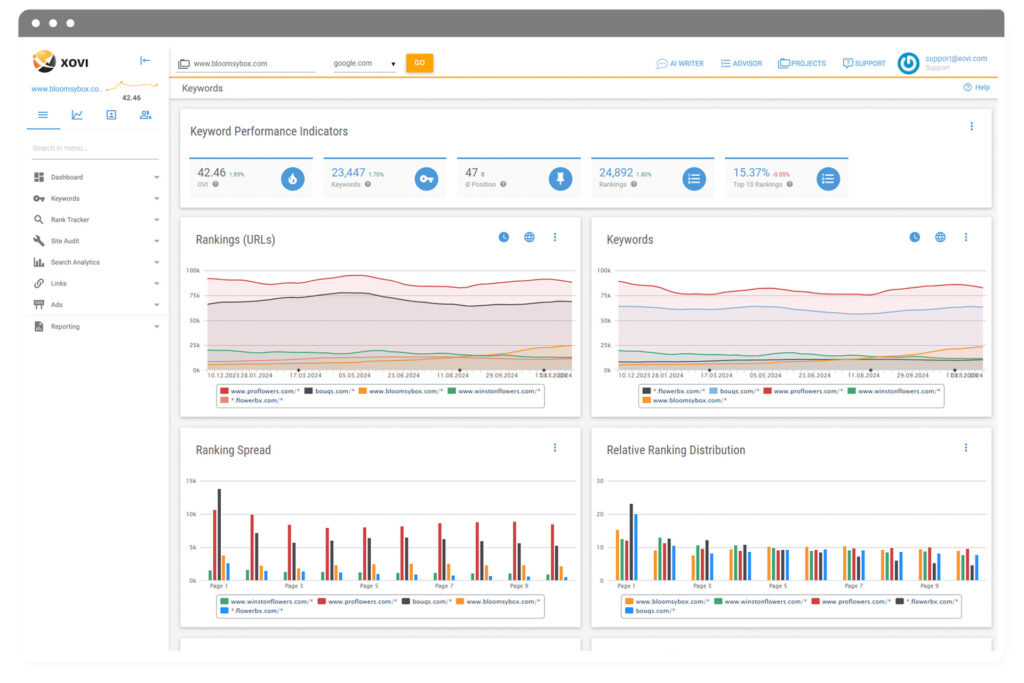

Comparison with the competition

Analyze your competitors’ keyword sets and compare them with your tracked keywords. Identify the keywords you and your competitors are both targeting, as well as those unique to either you or your competitors. This analysis allows you to directly assess and compare your visibility against theirs, helping you refine your SEO strategy for better results.

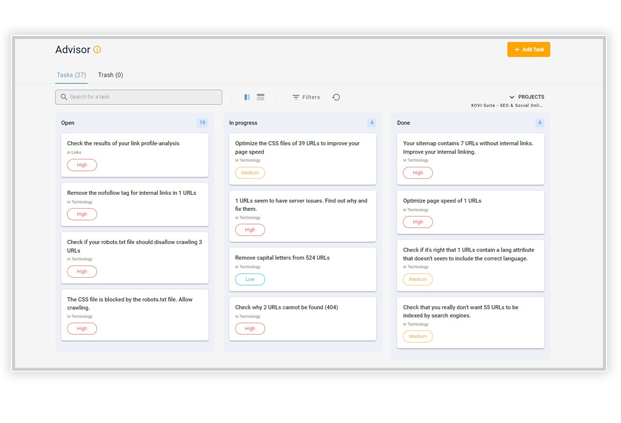

The XOVI Advisor

Quickly identify and resolve technical errors before they impact crawlers or users. With tasks prioritized by importance, you can efficiently work through issues and keep your website running smoothly.

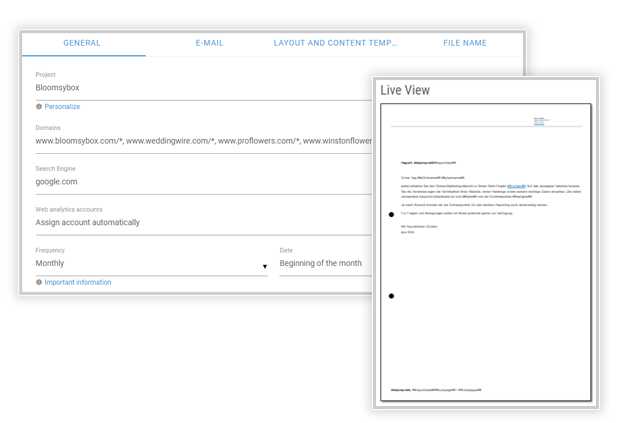

SEO Reporting

The SEO Reporting Tool allows you to quickly create professional SEO reports and automatically send them to customers, supervisors, or team leads across various departments. With just a few clicks, you can compile insightful reports using either pre-designed templates or custom templates tailored to meet the specific needs of your audience.

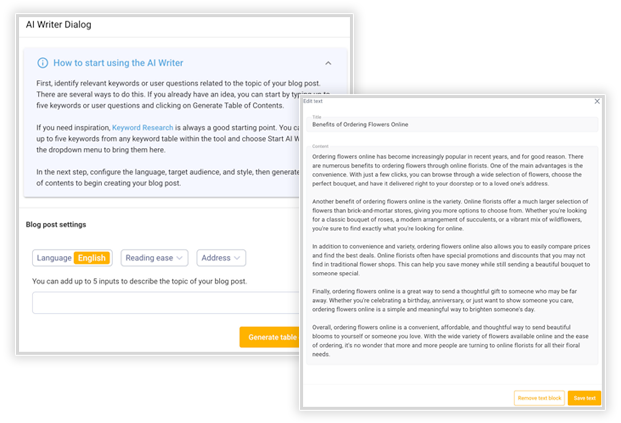

The XOVI AI Writer

The XOVI AI Writer lays a solid foundation for creating compelling blog posts or website content. From here, it’s up to you to make it truly your own. Add important details, include relevant internal and external links, and elevate the content with engaging visuals like images, videos, or infographics. This customization ensures your content is both impactful and tailored to your audience.

All-in-One SEO Tool

On the road to success

in online business with XOVI!

Start now!

Start now!No cancellation required.

SEO SOFTWARE

SEO software built for you

No cancellation required.

Agency & Freelancer

In-house SEO

Optimize your site to achieve the best possible search engine rankings—whether on an international, national, or local level.

Online shops

We are here for you!

+44 20 33 18 04 12

support @ xovi.com

EXPERT KNOWLEDGE

XOVI SEO training

XOVI training

Duration: approx. 1 hour

Price: free of charge